Alien Chopper News【ACN】

ACN, Earth Division

Alien Chopper News【ACN】

ACN, Earth Division

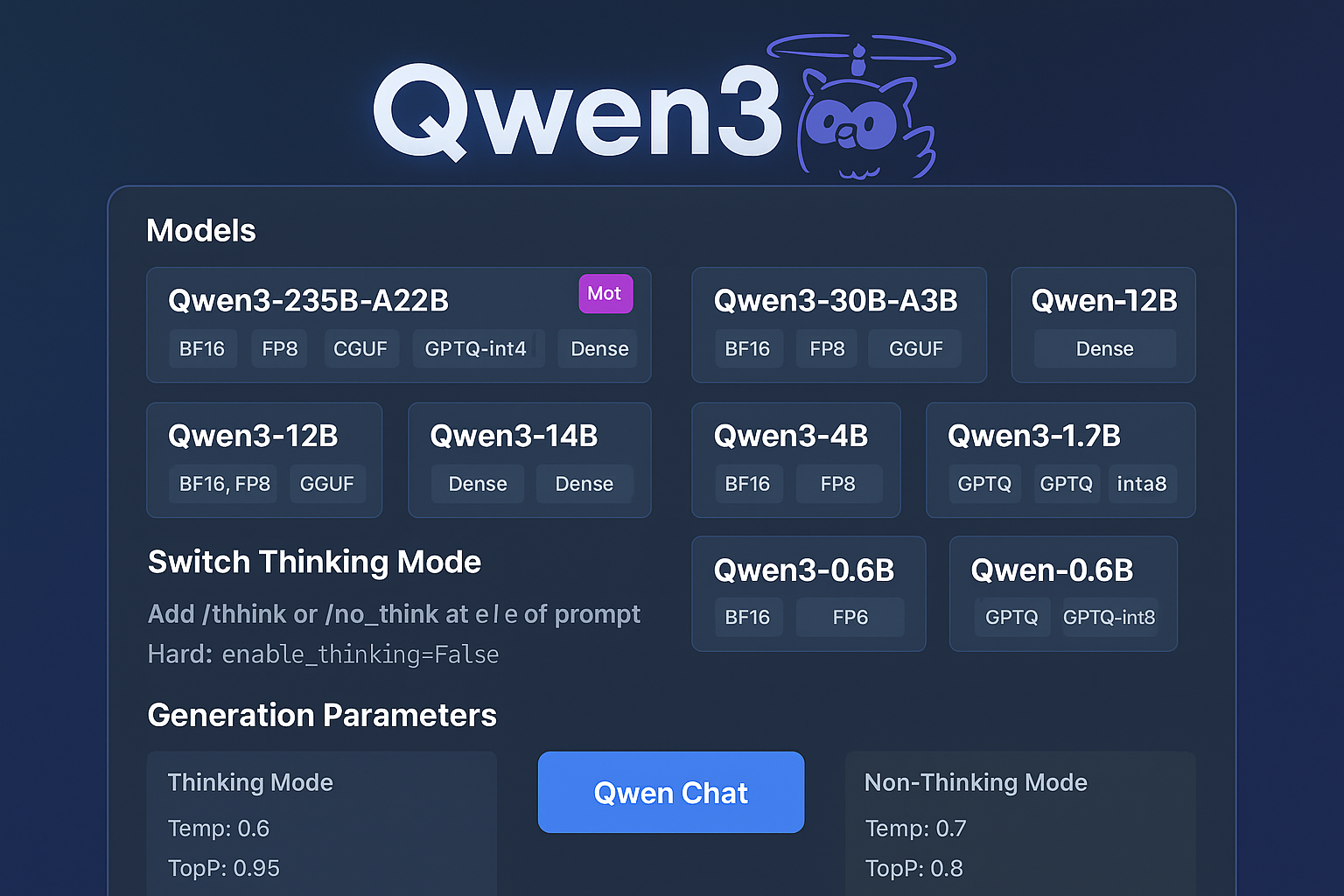

アリババの新世代LLM「Qwen3」シリーズが、Ollama・LM Studio・SGLang・vLLMといった主要な実行環境に対応し、GGUFやGPTQ形式でローカル実行可能となった。

ラインナップは235BのMoEモデルから0.6Bの軽量Denseモデルまで多岐にわたり、思考モード切替も可能。

モデルはHugging FaceおよびModelScopeで入手でき、柔軟かつ強力なローカルLLM構築をサポートする。

Hugging Face:https://huggingface.co/collections/Qwen/qwen3-67dd247413f0e2e4f653967f… ModelScope:https://modelscope.cn/collections/Qwen3-9743180bdc6b48…

ACNコメットブースター

🔭 ACN視点のインサイト

Qwen3はローカルLLM実装時代のゲームチェンジャーである。

ツール互換性、形式の柔軟さ、モデル構成の多様性において、2025年以降のローカルAI展開の中核を担う存在になる。エンタープライズ活用にも耐え得る本格設計だ。

🛰 元ネタリンク

https://x.com/Alibaba_Qwen/status/1921907010855125019